Mese: Agosto 2021

-

Una teoria per l’apprendimento di gruppo

C’è una visione dell’apprendimento che si potrebbe descrivere partendo da questo schema di sapore informatico: conoscenze = dati abilità = algoritmi competenze = saper applicare il corretto algoritmo ai dati relativi alla situazione attuale L’apprendimento consiste nell’acquisizione dei dati, nell’elaborazione degli algoritmi e nell’accumulo dell’esperienza che consente di scegliere gli algoritmi più adatti. Immagine tratta…

-

Basta coi dati, ancora più dati

Dati come algoritmi: ne parlano tutti, a qualsiasi proposito, a volte anche confondendoli. E si capisce, perché gli algoritmi senza dati girano a vuoto. Si legge e si ascolta sempre più spesso “I dati ci dicono che”, “Andiamo a vedere i dati”, “Ci vogliono nascondere i veri dati”. Ma a forza di citarli come risposta…

-

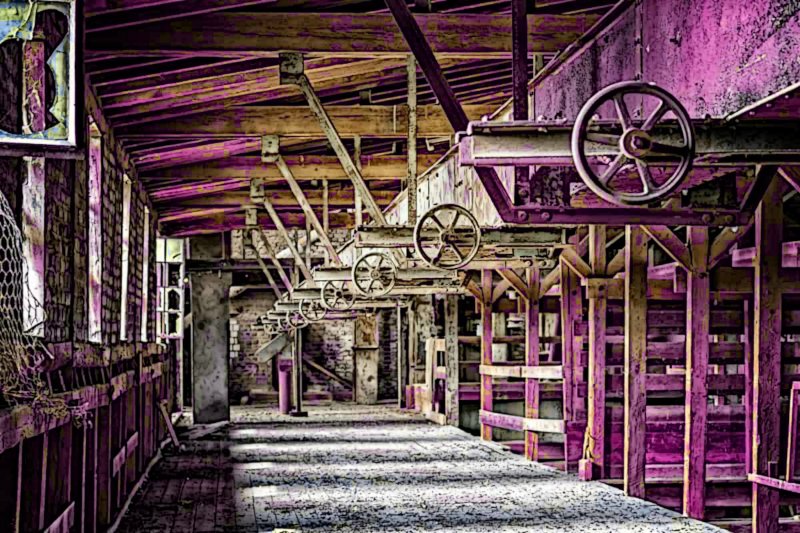

La fine della formazione

La formazione professionale ha senso se esiste una professione d’arrivo, cioè se esiste il contesto in cui una certa competenza può essere esercitata, riconosciuta, richiesta, pagata. Quando il contesto scompare, scompare la professione, e scompare anche la formazione. E’ questo lo scenario che ci aspetta grazie alla creazione di modelli di Machine Learning addestrati a…