Magari siete di fretta, avete da fare. Però qualcuno vi ha segnalato l’ennesima rivoluzione dell’AI, targata Microsoft. Non potete fare un figuraccia se qualcuno in una conversazione butta là “…un po’ come Vasa, no?” e voi non sapete se reagire con “interessante”, “io l’avevo già detto”, “roba da matti” o “dove andremo a finire?”. Per fortuna, questo articolo scritto da nove ricercatori di Microsoft Research Asia (https://arxiv.org/pdf/2404.10667.pdf) viene riassunto tre volte.

1. La prima è questa, in meno di 30 parole:

TL;DR: single portrait photo + speech audio = hyper-realistic talking face video with precise lip-audio sync, lifelike facial behavior, and naturalistic head movements, generated in real time.

TL;DR: significa “troppo lungo, non leggere”, ed è un modo scherzoso per introdurre un riassunto di un contenuto troppo lungo. Tradotto letteralmente: VASA-1 è una tecnica che prende un ritratto fotografico, aggiunge una registrazione audio di un discorso e produce un video iperrealistico di una volto parlante con sincronizzazione labiale precisa, mimica facciale verosimile e movimenti della testa naturali; il tutto generato in tempo reale.

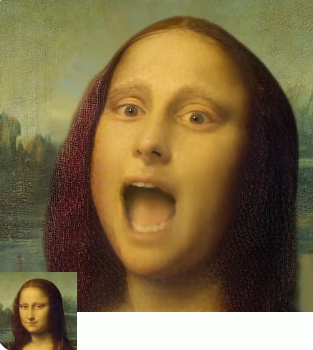

2. Poi c’è l’immagine che si vede sopra, che dice la stessa cosa per chi non fosse in grado di leggere.

3. Poi c’è un vero e proprio abstract di 175 parole. Che non riporto perché è troppo lungo.

Il tutto all’interno di una pagina web (https://www.microsoft.com/en-us/research/project/vasa-1/) , che contiene gli spettacolari video dimostrativi, il cui testo è a sua volta un riassunto dell’articolo stesso.

Già a me questa cosa sembra interessante: l’articolo in totale è lungo dieci pagine. Il che, per un articolo scientifico, non è poi tanto. Ma mi pare un segnale di questa cultura della brevità, in cui il valore è il tempo del lettore. Ma non era di questo che volevo parlare.

La ricerca del gruppo di Microsoft Research Asia ha prodotto dei risultati francamente affascinanti. Come sottolineano gli autori, il punto non è la possibilità di fare un video fake in cui Monna Lisa canta un brano rap (questo si era già visto), ma il fatto che avendo i due stimoli di partenza (la foto e la registrazione audio) il video può essere generato e controllato in tempo reale, in termini di persona, di movimenti oculari, di rotazione della testa, ma anche di espressione, come è dimostrato dalla registrazione di una demo. Il risultato è verosimile e il processo efficiente. Quindi si può immaginare un avatar che reagisca in tempo reale alla situazione, usando un parlato non registrato ma sintetizzato a partire da un testo prodotto da un software. Alexa, scànsate.

I punti interessanti, per me, sono due: i disclaimer etici che vengono immediatamente messi avanti dai ricercatori e i campi di applicazione dichiarati.

Cominciamo dai primi:

Note: all portrait images on this page are virtual, non-existing identities generated by StyleGAN2 or DALL·E-3 (except for Mona Lisa). We are exploring visual affective skill generation for virtual, interactive characters, NOT impersonating any person in the real world. This is only a research demonstration and there’s no product or API release plan. See also the bottom of this page for more of our Responsible AI considerations.)

In altre parole: “Tranquilli, noi non stiamo usando questa tecnica a partire da foto di persone reali, ma solo di personaggi fittizi, quadri, disegni, etc.” Certo, hanno un archivio con tutti i volti di tutti i personaggi famosi, e se si prova a usare quelli il software farà una pernacchia. “Inoltre, non abbiamo in programma di rendere questa tecnica disponibile al pubblico come Bing, Copilot, etc. L’abbiamo fatta così, per scherzo; e comunque resterà sempre nelle casseforti virtuali controllate da Redmond”. Tuttavia, si preoccupano di dire che funziona su PC da scrivania con una scheda grafica che costa meno di 2.000 €. Si vede che in casa Microsoft si sta attenti al budget per la ricerca.

It is not intended to create content that is used to mislead or deceive.[…] We are opposed to any behavior to create misleading or harmful contents of real persons.

Ovvero: “No, non è pensato per creare contenuti che verrano usati per imbrogliare. Anzi, non saremmo proprio contrari se qualcuno volesse creare contenuti a partire da persone reali.” E’ un po’ poco. Loro, i nove ricercatori, possono pensare onestamente quello che vogliono, ma la tecnica non è di loro proprietà e non saranno certamente loro a decidere come applicarla, sia in termini di contenuti che in termini di mercato. Fa un po’ tenerezza quest’immagine dei nove ricercatori cinesi che mettono le mani dietro la schiena, sorridono e dicono che no, la bomba non l’abbiamo fatta per uccidere persone, ma solo per festeggiare capodanno.

Ma passiamo invece ai campi applicativi:

The emergence of AI-generated talking faces offers a window into a future where technology amplifies the richness of human-human and human-AI interactions. Such technology holds the promise of enriching digital communication, increasing accessibility for those with communicative impairments, transforming education methods with interactive AI tutoring.

Non ci sono gli help desk, il supporto post vendita, gli assistenti casalinghi, la comunicazione politica, le notizie personalizzate, insomma i segmenti di mercato dove uno potrebbe pensare che si fanno i soldi sostituendo lavoratori remoti già sottopagati. No: salute e educazione. Ma forse è lì che si faranno i veri soldi in futuro. Cioè: il futuro dell’educazione è il tutor artificiale. Educazione è trasmissione uno a uno, o uno a molti; se al posto del docente c’è un avatar, e questo avatar è indistinguibile da un umano, siamo a posto. Perché occuparsi troppo di apprendimento, di costruzione collettiva del sapere e di tutte queste chiacchiere? Basta mettere un docente (artificiale) simpatico in cattedra e il gioco è fatto. D’altra parte Nao & compagni non sono lontanissimi.

Più avanti, nella parte finale relativa alla responsabilità etica:

The benefits – such as enhancing educational equity, improving accessibility for individuals with communication challenges, offering companionship or therapeutic support to those in need, among many other – underscore the importance of our research and other related explorations. We are dedicated to developing AI responsibly, with the goal of advancing human well-being

Non è bellissimo? Ci sono queste persone svantaggiate il cui problema principale è non avere degli umani che parlano con loro. Perché vivono in Groenlandia, dove scarseggiano gli umani capaci di intrattenerli? Boh, non è chiarissimo. Ma dove gli umani non arrivano, arriva VASA-1. Ovviamente gratis, sia in termini di servizio multimediale che di generazione di contenuti. E noi che credevamo che l’educational disequity fosse un problema di soldi.

Che bello.