Parto invitandovi a leggere questo articolo di Wired in cui Andrea Indiano dà conto della moda recente di usare generatori automatici di immagini a partire da testo per “arredare visivamente” clip audio.

I generatori di immagini da una descrizione (txt2img) sono un po’ l’inverso dei software che riconoscono soggetti all’interno di foto. Questi ultimi sono diventati quasi standard (anche le immagini caricate su Facebook passano per questo tipo di analisi) e se ne parla solo a proposito della liceità dell’uso di questi algoritmi nel caso del riconoscimento dei volti umani in regimi totalitari. O in regimi. Insomma, ovunque.

Qui invece di solito si parte da un testo che descrive una situazione un po’ come i sottotitoli per non udenti. Solo che qui la descrizione non è limitata dalla realtà, anzi non descrive ma crea. Ad esempio: “un cerbiatto rosa sulla luna che sorseggia una coca-cola.” Qualche filosofo direbbe che è un caso eclatante del potere del linguaggio che non rappresenta il mondo ma lo porta all’esistenza.

L’idea è provare a utilizzare lo stesso strumento non con un testo descrittivo fatto apposta, ma con le parole di una canzone. Un esempio: The Sound of Silence, di Simon&Garfunkel. Oppure: Space Oddity di David Bowie.

L’uso di immagini per riempire il vuoto visivo di una canzone pubblicata in un canale video-centrico come Youtube non è una novità. E’ sempre più difficile imbattersi in un clip video che ripropone una vecchia canzone di Fabrizio De André con l’immagine fissa della copertina del disco originale. Se c’è, è stato pubblicato parecchi anni fa. Come minimo oggi ci sarebbero le sequenze in dissolvenza delle foto dei concerti oppure delle immagini “di repertorio” rubate qua e là (una stazione per “Bocca di Rosa”, un mucchietto di diamanti per “Città vecchia”, eccetera). Se non siete boomer, non potete capire.

La novità è invece che si comincia a trovare un uso sensato di questa funzione di “frullatore intelligente di immagini”. Come spesso succede, non si tratta di un uso davvero nuovo di una funzione nuova, ma della replica accelerata di qualcosa che esisteva. Nella versione tradizionale c’è un umano che gira per depositi di immagini free (come Pixabay o Unsplash), cerca e seleziona immagini sulla base delle parole del testo; nella versione AI questo processo viene coagulato in un’azione singola affidata ad un software. En passant viene anche risolto il problema del copyright generando immagini nuove che superano il vincolo della licenza d’uso (almeno per ora: il diritto d’autore dovrà aggiornarsi).

Sembra che i generatori più usati per dare una controparte visiva ai clip audio siano Dall-E, Midjourney ma anche Stable Diffusion . Magari a voi sembrano tutti uguali, ma non lo sono: per quanto quasi tutti siano gratuiti almeno nella versione limitata, alcuni sono anche scaricabili e utilizzabili sul proprio PC, o persino modificabili, grazie ad una licenza opensource, mentre altri sono proprietà dell’azienda che li ha sviluppati e che ne permette l’uso come servizio web, più o meno gratuito, più o meno vincolato. Però una cosa è un ragazzetto del Minnesota che si diverte a creare videoclip a partire dai suoi brani preferiti e una cosa sarebbe Youtube che introducesse una funzione che associa automaticamente le immagini a qualsiasi clip audio caricato dagli utenti. Nel primo caso il controllo finale è ancora in mano all’utente/cliente, nell’altro sarebbe completamente in mano del fornitore di servizi. Non della “rete”, soggetto generico onnipresente, ma di un determinato attore del mercato globale che persegue suoi obbiettivi economici, di comunicazione, di ricerca etc. in totale (e legittima) autonomia. Per esempio, Youtube potrebbe usare una qualità più bassa, oppure delle immagini leggermente sgradevoli, in associazione a certi clip audio per scoraggiarne l’uso o per indurre un sentimento negativo negli spettatori.

Era questo l’obiettivo dei ricercatori che hanno messo a punto Dall-e o Midjourney? Credo di no. OpenAI, la società californiana che sviluppa Dall-e 2, è stata fondata da Elon Musk ed è finanziata da Microsoft; Imagen è sviluppato da Google.

Magari il prossimo passo sarà la produzione di un cartone animato o di un videogioco, visto che cinema e videogiochi sono un mercato enorme e che hanno dei costi di produzione legati alla manodopera specializzata umana ancora altissimi. Per un buon “training” dei modelli però non basta avere sterminati archivi di immagini a disposizione: occorre anche la valutazione degli utenti finali. Di qui l’interesse a permettere l’uso delle versioni beta di questi software a più persone possibile. Più giochiamo con Dall-E, più aiutiamo Microsoft, gratis.

Quindi usare l’uno o l’altro è anche una questione di scelta politica, non solo estetica. Tenere conto di questi aspetti quando si riflette e si scrive di applicazioni dell’IA alla vita dovrebbe essere ovvio; a giudicare da quel che si legge invece non lo è.

Potremmo fermarci qui e invece andiamo avanti. “Questa non è intelligenza!“: può darsi che questa frase vi sia venuta in mente guardando i videoclip.

Non siete i soli. Ci sono state discussioni infinite sull’intelligenza della macchina, o del software che l’ha prodotta, o del gruppo di programmatori che ha scritto il software. Infatti la prima domanda è: chi è il soggetto in questo caso? Chi è l’ente che si nasconde dentro l’intelligente?

La sorgente di queste discussioni sta nel fatto che questi software sono applicazioni di machine learning, ovvero non sono intelligenti nella interpretazione consueta dell’aggettivo. Non ragionano sulla base di regole, non deducono, non cercano percorsi alternativi.

Quello che farebbe un software tradizionale è costruire una query (una stringa di ricerca) basata sulle parole fornite dall’utente (nel caso di sopra, il verso della canzone) e sulle loro relazioni. La query verrebbe passata ad un motore inferenziale capace di astrazione (per esempio, da “Bambi” sarebbe in grado di dedurre cerbiatto, cervo, mammifero, quadrupede, animale). Applicata ad un archivio di miliardi di immagini la query restituirebbe un certo numero di immagini che poi sarebbero state mixate, filtrate, adattate in base anche allo stile impostato dall’utente-creatore.

Invece le applicazioni di machine learning funzionano diversamente. Partono direttamente dall’archivio di immagini marcate con parole o valutazione di utenti umani (prese da Pinterest, Flickr, Wikipedia etc) e le utilizzano per costruire dei modelli; poi analizzano il testo di input e lo forniscono come filtro al modello che produce letteralmente la nuova immagine. Tutto sta nel modello, e infatti è la parte più complicata e costosa da produrre.

Un modello è sostanzialmente costituito da un numero enorme di parametri, cioè di coppie proprietà/valore. Un triangolo è un tipo di modello, ma ha solo sei parametri: la misura degli angoli e la lunghezza dei lati. Se si volesse costruire un modello di un triangolo fisico occorrerebbe aggiungere altri parametri: la posizione nello spazio, il peso, il tipo di materiale, il colore. Un modello di una perturbazione meteorologica è molto, molto più complesso. I modelli usati dai software di machine learning possono avere miliardi (letteralmente) di parametri.

E’ fondamentale, nella prima fase, l’utilizzo dei commenti da parte di umani per la marcatura delle immagini. Qui l’aspetto quantitativo è vincente, e come è ovvio introduce enormi bias culturali: se si prendono solo i commenti in inglese, si replica la maniera di vedere il mondo degli umani anglofoni, se non statunitensi o britannici.

E’ la fine dell’arte, è la fine delle scuole d’arte? Dopo gli autori di traduzioni, di recensioni, di musica, ora gli autori di quadri andranno in pensione anticipata? Ne abbiamo già parlato qui.

Torniamo alla nostra frase: “Questa non è intelligenza”.

In questa frase ci sono, a mio parere, tre errori; errori che non fanno sicuramente (più) gli scienziati che si occupano di intelligenza, dagli psicologi ai neurobiologi, ma che facciamo più o meno tutti quando ragioniamo affacciati alla finestra di qualche social network, cioè la maggior parte del tempo:

- che l’intelligenza sia innata, data una volta per sempre agli umani (e non alle macchine), purtroppo in maniera variabile;

- che l’intelligenza sia assoluta e non relativa ad un contesto, ad una situazione;

- che l’intelligenza tout court coincida con la forma di intelligenza codificata nel mondo adulto occidentale.

A questo punto la tradizione vuole che ci si interroghi sul significato della parola. Cos’è l’intelligenza? Domanda a cui sono state date tante risposte quanti erano i contesti storici, politici, sociali in cui è stata posta. Difficile dire quale sia quella corretta in assoluto, difficile persino parlare di correttezza e scientificità per una definizione di qualcosa che assomiglia più ad un assioma che ad un teorema, nel senso che è un presupposto e non qualcosa di dimostrabile. Probabilmente è uno dei costrutti chiave del Novecento, così come nell’Ottocento un costrutto fondamentale era “lavoro”. Anzi, si potrebbe forse dire che una delle differenze tra Ottocento e Novecento è proprio il passaggio dall’organizzazione e efficientamento del lavoro degli operai potenziando i loro muscoli con quelli della macchina a vapore alla sostituzione dell’intero lavoro fisico con l’intelligenza; passaggio che sfrutta il concetto di macchina e lo trasforma in quello di automa. Ma qui divagheremmo troppo.

Molte sono le definizioni che, a mio parere, si limitano a spostare il problema, cioè usano nella definizione termini che a loro volta dovrebbero essere definiti (“the capacity… to think rationally“, Wechsler; “the ability to deal with cognitive complexity”, Gottfredson) fino a quelle ricorsive (“L’intelligenza è ciò che è misurato dai test di intelligenza”, Boring). Ci sono le definizioni che puntano sull’adattamento all’ambiente (Binet, Feuerstein) e quelle che sottolineano il raggiungimento di obiettivi (Legg e Hutter, Stemberg e Salter). Tutto questo lo potevate trovare su Wikipedia ma vi ho risparmiato la fatica di cercarlo.

Quella che mi convince di più è una definizione più filosofica che psicologica: “L’intelligenza è l’abilità di mettere ordine in una situazione complessa con il minimo consumo di risorse“. Questa definizione si basa su due valori molto generali: l’ordine è preferibile al caos, da un lato, e il risparmio di energie è preferibile allo spreco. Il primo valore ha a che fare con l’ambiente, il secondo con il soggetto che si trova in quell’ambiente. L’intelligenza mette in relazione questi due valori, ne cerca un equilibrio. Come dire: sarebbe bellissimo avere una situazione perfettamente ordinata, ma non al prezzo di consumare tutte le risorse disponibili. Una situazione ordinata è una situazione prevedibile, con meno rischi; non sprecare risorse e tenersene da parte un po’ per i giorni di pioggia è un altro modo di ridurre i rischi. Inutile ridurre da una parte e aumentare dall’altra. Oppure sì, ma va tenuto d’occhio l’ago della bilancia.

E’ una definizione di chiaro sapore evoluzionistico, ma avevo avvertito che si trattava di una definizione filosofica, non scientifica.

A mio parere ha diversi vantaggi. Intanto è un modo di ricordarsi che l’intelligenza non è buona o cattiva in sé, ma solo in un contesto determinato, come meta-strumento per ottenere risultati che – loro – sono considerati positivi: la conservazione in vita dell’individuo, la trasmissione del patrimonio genetico.

Non fa riferimento a concetti legati alla mente, ma solo al fatto (puramente organico) che usare i muscoli per spostare un masso consuma più energie che immaginare di farlo. Una volta ho letto un romanzo fantasy in cui fare una magia “costava” al mago, non proprio lo stesso sforzo dell’azione reale ma qualcosa di proporzionale. Non è un paragone fuori luogo: la magia è una forma di intelligenza.

Questa abilità è considerata un valore dal punto di vista dell’individuo, al punto da cercare di misurarla con dei test, perché è un valore dal punto di vista della comunità. Una comunità fatta di persone intelligenti è più efficiente, si conserva meglio nel tempo, cresce.

La Grecia classica, Atene in particolare, aveva puntato su questo valore a livello di cultura: i sofisti, i retori, i filosofi sono un’immagine concreta del valore che si attribuiva alla capacità del cittadino di ragionare con la sua testa e decidere. La Grecia aveva portato questo valore anche a livello di politica estera, ritenendo possibile sconfiggere l’impero persiano, così tanto superiore per potenza di armi e uomini, con la strategia, gli accordi tra città e la pianificazione.

Ma si può leggere in questo modo l’intera evoluzione umana, raccontando una storiella come questa: tanti anni fa, puntando sull’intelligenza, sulla categorizzazione di situazioni apparentemente diverse, sulla previsione, sulla pianificazione, i primi umani riuscirono a sopravvivere in un contesto in cui c’erano animali ben più forti e resistenti. L’intelligenza si cristallizza in strumenti: un utensile non è altro che un’astrazione di infiniti possibili contesti d’uso. L’intelligenza si trasmette attraverso le generazioni, se nel frattempo si inventa un linguaggio.

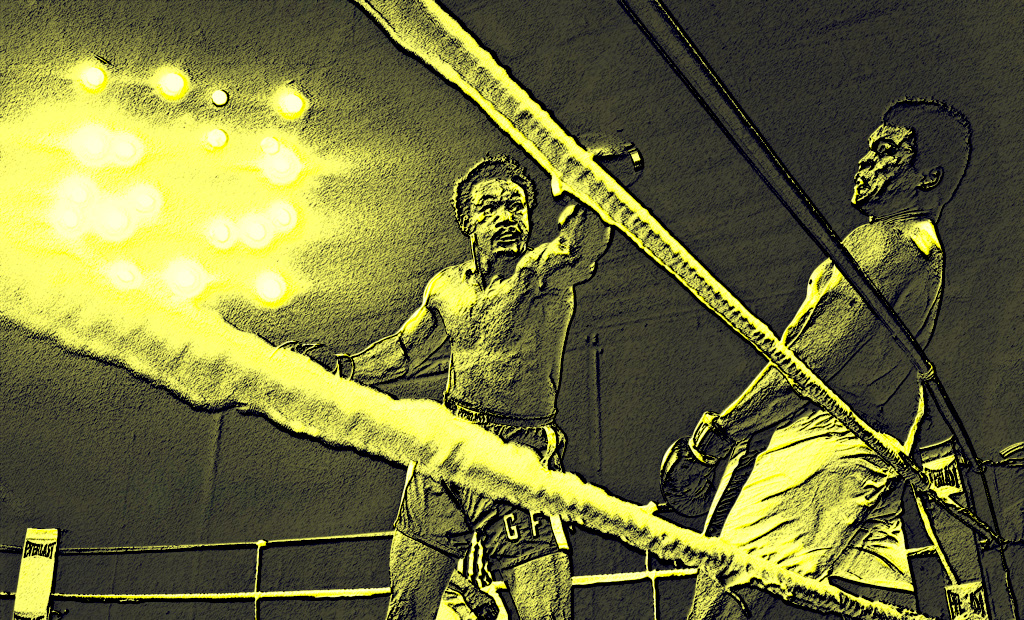

Forse individualmente non siamo ancora perfettamente tranquilli nello scommettere sull’intelligenza contro la forza in tutte le occasioni. Non tutte le battaglie sono vinte grazie alla flessibilità della tattica o per merito della migliore armatura (come nel 490 a Maratona). Quando a Kinshasa nel 1974 Mohammad Alì vince contro George Foreman – che era dato per favorito 3:1 – fa scalpore e ce lo ricordiamo perché di solito quando si fa a pugni vince il più forte (che era Foreman: più giovane di sette anni, più alto, più pesante). Alì inventa una tecnica intelligente (rope-a-dope: usa le corde del ring per assorbire la forza dei pugni di Foreman) che dopo quella volta viene riusata anche da altri pugili.

Malgrado questo, come specie, siamo fondamentalmente convinti che l’intelligenza sia una strategia vincente, tant’è che ci affanniamo a insegnarla ai cuccioli d’uomo, anche quando non devono affrontare tigri e serpenti. Curiosamente, non lo facciamo frontalmente, ma per vie traverse. A scuola non si insegna intelligenza, ma matematica, fisica, magari coding. Certo si fa anche educazione motoria, ma non c’è paragone quanto a risorse dedicate.

Ma perché allora non puntare direttamente all’apprendimento dell’intelligenza? Perché ricorrere a giri di parole come “lo studio del Latino insegna a ragionare”? Credo che la risposta sia semplice: perché non abbiamo idea di come altro si possa fare. Non abbiamo idea di come insegnare la capacità di risolvere problemi senza dei problemi concreti da cui partire. Pensiamo di poter dire che l’esercizio della traduzione, o quello della soluzione di equazioni, favorisce l’abilità generale che chiamiamo intelligenza: ci sembra che chi lo pratica per un certo tempo poi sia in grado di affrontare anche altri tipi di problemi e inventare soluzioni economiche. In questa prospettiva si spiega la posizione privilegiata di matematica, fisica e oggi di informatica nei curriculum scolastici di mezzo mondo. Non è tanto il fatto che le STEM (science, technology, engineering and mathematics) in quanto tali siano importanti per la professione futura (anzi, forse lo sono sempre di meno), ma il fatto che grazie al loro insegnamento manteniamo e potenziamo l’intelligenza della specie.

La matematica è un’applicazione dell’intelligenza agli aspetti del mondo che si possono quantificare. Per scambiare pecore con orci d’olio ci sono due modi: uno richiede di accoppiare fisicamente le une e gli altri fino ad ottenere una parità; l’altro si limita a contare orci e pecore e a confrontare i numeri.

La fisica è un’applicazione dell’intelligenza alla previsione del comportamento di alcuni aspetti della materia, come la posizione, che cambiano spesso. Ci piacerebbe sapere in anticipo come cambiano questi aspetti; ma invece di aspettare e vedere che succede, si possono costruire delle regole, applicarle ripetutamente (simulazioni) e confrontare i numeri finali. Questi set di regole si chiamano “modelli”. Il risparmio, in questo caso, non è di fatica muscolare ma di tempo, che è comunque una risorsa fondamentale.

La chimica è una cuginetta più giovane della fisica: si occupa di trasformazioni profonde della materia, quelle per cui gli oggetti diventano altro. Lo fa allo stesso modo delle fisica, cercando di costruire modelli matematici unici di contesti che sembrano diversi, a costo di mettere in gioco elementi invisibili ma che hanno un peso. Lo sforzo di pensare la struttura profonda della materia è ricompensato con una capacità di produrre materia nuova usando quella che esiste. Rinunciando a vedere la materia, mettendo tra parentesi i sensi, facciamo un’ottimizzazione che ci consegna un maggior poter sul mondo.

La teoria generale dell’insegnamento dell’intelligenza è dunque questa: fare pratica dell’uso di schemi di ordinamento di situazioni complesse in domini limitati, ristretti, sperando che questa esperienza si coaguli in competenza, cioè in capacità di riapplicare al momento giusto alcuni degli schemi che abbiamo sperimentato positivamente in passato. Non si offendano i docenti di matematica e scienze: non c’è una grande evidenza sperimentale che questo metodo funzioni, ma è talmente diffuso che non lo mettiamo nemmeno in discussione.

Anche l’informatica è un’applicazione dell’intelligenza agli aspetti del mondo, sulla stessa strada di matematica, fisica e chimica. Solo che non esclude nessun oggetto e nessun aspetto: prende luci, suoni, movimenti e trasforma tutto i numeri. Ambisce a costruire modelli di tutto ciò che ha una forma: dalla forma degli oggetti allo schema delle relazioni sociali, da quella del territorio al profilo dei clienti. Su questi modelli applica algoritmi che consentono di misurare, prevedere cosa succederà, creare oggetti nuovi (anche se solo virtuali). Il doppione del mondo che mira a costruire è un’incarnazione perfetta dell’intelligenza: tutto forma e niente materia, replicabile, indistruttibile, pulito, razionale.

Naturalmente, con buona pace di Leibniz che sperava che un giorno tutti i filosofi si sarebbero messi a calcolare invece di discutere vanamente, gli algoritmi informatici richiedono un velocità di calcolo che i nostri cervelli singoli non hanno. Per quanto un famoso teorico dal cognome impronunciabile abbia detto che “L’informatica non riguarda i computer più di quanto l’astronomia riguardi i telescopi”, invece l’informatica senza i computer – computer sempre più veloci – non servirebbe a nulla.

Qui si apre un bivio tra apocalittici e integrati. C’è chi ritiene che per renderci davvero intelligenti l’informatica ci chiede di rinunciare non solo ai muscoli, ma a tutto il corpo, fino a sostituire il soggetto organico con un agente meccanico capace di mettere ordine consumando pochissime risorse (così almeno promette; in realtà si comincia a capire che il consumo di elettricità dei centri di calcolo dove risiedono le applicazioni e i dati che insieme costituiscono il “cloud” dovrebbe essere tenuto sotto controllo). Quindi insegnare il coding a scuola è inutile e contraddittorio: mentre insegniamo l’informatica ai bambini, l’informatica si sta sviluppando nella direzione di rendere vano questo sforzo didattico. E’ lo spettro evocato da tanti romanzi e film di fantascienza: quando i robot diventeranno intelligenti non avranno più bisogno di noi.

C’è chi invece pensa che l’informatica si limiti a supportarci, come un’estensione buona della nostra intelligenza ma all’esterno del nostro corpo. Non sostituisce ma potenzia. Ci permette finalmente di trasformare dati in informazioni, in conoscenze e forse in sapere. Ci rende la vita più piacevole, ci libera dalla fatica di ricordare. Come diceva in una delle sue battute meno riuscite Aristotele: gli schiavi (digitali) permettono agli uomini liberi di avere più tempo da dedicare alla filosofia. Quindi insegnare coding a scuola e fuori fa bene all’intelligenza dei ragazzi, che impareranno finalmente a pensare in maniera razionale, logica, senza errori, come dei bravi computer.

Entrambe queste visioni, a mio parere, sono astratte. L’informatica non è un soggetto, non ha obiettivi, non va da nessuna parte da sola. Le ricerche più avanzate nei domini dell’intelligenza artificiale si fanno fuori dalle università. Le sperimentazione con miliardi di utenti vengono gestite da aziende che hanno un obiettivo di business immediato e un piano più generale di conquista dei mercati.

Sono aziende guidate da persone che rispondono agli azionisti.

D’altra parte, come detto prima, l’informatica ha bisogno di hardware e l’hardware costa. Il supercomputer Leonardo, inaugurato a Bologna pochi giorni fa, è capace di un miliardo di miliardi di operazioni al secondo ma è costato 240 milioni di euro. Però il costo maggiore non è quello dei transistor: è quello dell’elettricità che serve per farli funzionare. E’ noto che Alphabet, l’azienda che è proprietaria di Google, ha coperto i suoi centri di calcolo di pannelli fotovoltaici per prodursi in casa l’energia necessaria e non doverla comprare da nessuno. Una buona cosa, no? Certo, basta sapere che fine faranno quei pannelli quando non saranno più produttivi. O, da un altro punto di vista, basta sapere l’impatto che può avere sull’economia di un Paese l’arrivo di una google-farm che comincia a produrre e a rivendere energia elettrica ad un costo competitivo rispetto a tutti gli altri attori del mercato, fino a conquistare il monopolio.

Cosa c’entra il coding? Beh, il coding non andrebbe né rigettato come contagioso, né sposato come strada maestra per insegnare l’intelligenza ai bimbi. Dovrebbe essere appreso come un mezzo particolarmente efficace didatticamente per simulare il mondo (matematico, fisico, chimico, biologico, linguistico,musicale,geografico,…), fare ipotesi e verificarle senza necessariamente andare dietro alle ultime opinioni che abbiamo sentito in giro; ma anche un modo per capire come funziona il mondo sociale: che società ci aspetta? chi decide cosa possiamo vedere e sentire, cosa possiamo leggere, con chi possiamo comunicare? Usare i robot in classe dovrebbe permettere di interrogarsi insieme su cosa succederà quando tutti i lavori saranno svolti da robot. Andare a caccia di dati (per esempio, sull’ambiente) dovrebbe essere un modo per rendersi conto del loro valore e scoprire che non tutti li rilasciano allo stesso modo, o che non tutti i motori di ricerca sono agnostici. Scrivere piccoli programmi potrebbe essere un modo per riappropriarsi dei computer e sfruttarli per fare qualcosa di utile prima di tutto per noi, come speravano negli anni sessanta gli inventori degli home computer e dei linguaggi di programmazione per tutti.

Potremmo ancora dire che fare coding aumenta l’intelligenza? Senz’altro, anche se non nel senso che insegna a diventare computer. Anzi, insegna a non farsi programmare.

Ma quale intelligenza?

La forma di intelligenza che prevale nella nostra culture è quella adulta e formalizzata. Quella che si può descrivere mentre si applica, in cui i passi sono consapevoli e si possono identificare ed etichettare. E’ l’intelligenza formalizzata, la logica. Il meccanismo principale, potremmo dire il motore che la fa girare e che produce risultati, si chiama “deduzione”. I filosofi hanno passato duemila anni a raffinarla, a porre dei limiti a cosa può fare o non fare, fino a dire che se è definita proprio precisamente potrebbe applicarla anche una macchina. La possiamo chiamare intelligenza di tipo B.

Perché B? perché i bambini appena nati non hanno questo tipo di intelligenza, ma iniziano a cercare di categorizzare il mondo e a selezionare le risposte che mettono ordine. Categorizzano milioni di aspetti e situazioni, ipotizzano azioni, le sperimentano, le scartano. Questo è il mondo fondamentale con cui la specie umana (e probabilmente tutte le specie animali superiori, e forse anche tutte le specie viventi) acquisiscono intelligenza. Questa la chiamiamo intelligenza di tipo A. E’ il tipo di intelligenza che ci appartiene di più, come essere umani, perché non ce la deve insegnare nessuno. Anzi, senza di lei, non sapremmo neppure che ascoltare un adulto esperto in generale è una buona idea, perché se è ancora vivo forse può insegnarci qualcosa che non sappiamo.

Decisamente curioso allora è il fatto che quando parliamo di intelligenza per sottrazione (“i computer non sono veramente intelligenti, gli mancano X, Y e Z”) facciamo riferimento ad una forma di intelligenza che tutto sommato è più loro che nostra.

Fatto sta che l’industria dei computer non poteva fermarsi. Tutti i dispositivi elettronici sono un po’ intelligenti, nel senso che sanno fare velocemente cose molto complicate, adattandosi al contesto, soprattutto se sono connessi tra loro. Ma insomma i PC non hanno realizzato quell’eden che ci avevano promesso: ci tocca ancora alzarci la mattina per lavorare, anche se da casa. Certo un produttore di hardware non vuole smettere di creare e vendere macchine sempre più veloci e potenti per il motivo banale che alle persone comuni non servono a nulla. Tra l’altro qualcuno quelle macchine se l’era comprate davvero: tante macchine, molto grosse. Una volta impiegato il 10% della loro potenza per fare ricerche o vendere libri col restante 90% qualcosa dovevano pure farci.

Insomma, dopo aver fallito nel dare l’intelligenza di tipo B alle macchine (cioè a formalizzare comportamenti intelligenti per compiti non banali o non quantitativi in modo da renderli eseguibili da macchine), siamo tornati al tipo A e abbiamo “riscoperto” il machine learning: un soggetto che cerca di categorizzare il mondo sperimentando risposte organizzative. Mentre però una specie animale impiega milioni di anni, e un individuo parecchi anni, le grosse macchine attuali impiegano molto meno tempo, ore o al massimo giorni. Diciamo che i muscoli, in questo caso, sono al servizio dell’intelligenza, nel senso che la crescita della pura potenza di calcolo di un computer nel corso degli ultimi settant’anni è stata molto, ma molto superiore a quella di qualsiasi organismo vivente. La cosiddetta Legge di Moore ipotizza che la potenza di calcolo dei computer raddoppi ogni due anni. E’ una legge empirica che non tiene conto di tantissimi altri fattori, ma indicativamente significa che dai primi computer degli anni ’50 ad oggi la potenza è raddoppiata 35 volte. 2 alla 35 fa 34 miliardi e spicci: è la misura di quanto i computer di oggi sono più potenti dei primi.

Va detto a onore dei filosofi che questa prima forma di intelligenza l’avevano definita da un pezzo: si chiamava “induzione”. Piaceva tanto agli inglesi nel ‘600: se vedo un corvo nero, può essere un caso. Se ne vedo 10, comincio ad avere dei dubbi. Se tutti i corvi che vedo sono neri, allora è un complotto oppure tutti i corvi sono neri, cioè “nero” è una proprietà necessaria dei corvi. Però già sapevano che è un’intelligenza un po’ rozza, approssimativa, non porta sempre a risultati corretti: esistono i corvi albini. Anzi il problema è proprio che non si sa se i risultati sono corretti. Inoltre il risultato dipende fortemente dalle prime osservazioni, che portano a puntare in una certa direzione, cioè a cercare animali alati e neri. Non possiamo fare a meno di usare l’induzione ma sappiamo che non ci possiamo fidare completamente.

E’ di qualche giorno fa la notizia che Meta ha temporaneamente ritirato Galactica, un motore di ricerca “intelligente” specializzato nelle produzione di abstract da pubblicazioni scientifiche, basato ovviamente sul machine learning, perché produceva dei risultati falsi.

Ancora una volta i filosofi, nella loro passeggiata guardando le stelle, un attimo prima di cadere in un pozzo, avevano scritto che siamo incastrati tra due forme di intelligenza limitate: la deduzione che non porta niente di creativo e l’induzione che non porta niente di sicuro. Poi hanno provato a definire forme nuove di intelligenza, con risultati un po’ dubbi. Ma almeno hanno indicato una direzione, ci hanno suggerito di cercare di non restare bloccati nel dilemma, o per lo meno di cercare di non prenderci per dèi.

Tanto per riassumere, all’americana: l’intelligenza è un’abilità che si acquisisce, si perfeziona. Certo occorrono delle basi neurologiche, come occorre un contesto stimolante. Ma il processo di acquisizione non si può bloccare, neanche volendo, perché funzioniamo così.

L’intelligenza non è un’abilità assoluta, indipendente dalla cultura, dalla lingua, dall’età. L’intelligenza assume forme diverse in funzione della situazione problematica che va affrontata.

Abbiamo deciso, come specie e come continente, di privilegiare una certa forma di intelligenza, che è facilmente riconoscibile e (pare) facilmente insegnabile. Ne abbiamo fatto un valore a sé, dimenticando che è solo un mezzo conveniente, efficace fino ad un certo punto. Ce ne siamo accorti quando abbiamo tentato di concedere questo tipo di intelligenza a certe macchine, con risultati così così.

Allora qualcuno si è ricordato che c’è almeno un’altra forma di intelligenza, che dovremmo conoscere molto bene ma che tendiamo a scordare, che si può cablare nelle macchine. Così sono stati creati dei bambini digitali che pasticciano, scarabocchiano, cantano imparando da noi. Staremo a vedere quanto ci mettono a diventare adulti. Poi se li chiudiamo in una stanza e gli diamo da vedere solo cartoni animati, beh forse adulti non ci diventeranno mai.

Infine: si sviluppa la propria intelligenza in tante maniere, e tra queste c’è quella di creare mondi virtuali, fare ipotesi e verificarle immediatamente tramite la programmazione dei computer. Magari applicando questa tecnica anche agli stessi computer, le reti e ai servizi che passano attraverso: come funziona? dove va a finire questo filo? chi c’è dall’altra parte dell’antenna?

Ah, a proposito: l’informatica non è un prodotto dello spirito del tempo.

Lascia un commento

Devi essere connesso per inviare un commento.